Google DeepMind Apresenta Gemini Diffusion: Uma Mudança de Paradigma na Geração de Texto por IA

O Google DeepMind anunciou ontem Gemini Diffusion, um modelo de linguagem experimental que aplica a abordagem de ruído para sinal da geração de imagens ao texto pela primeira vez em escala de produção. O avanço promete geração de texto significativamente mais rápida com coerência aprimorada, potencialmente revolucionando a abordagem dominante para grandes modelos de linguagem que tem definido o desenvolvimento da IA por anos.

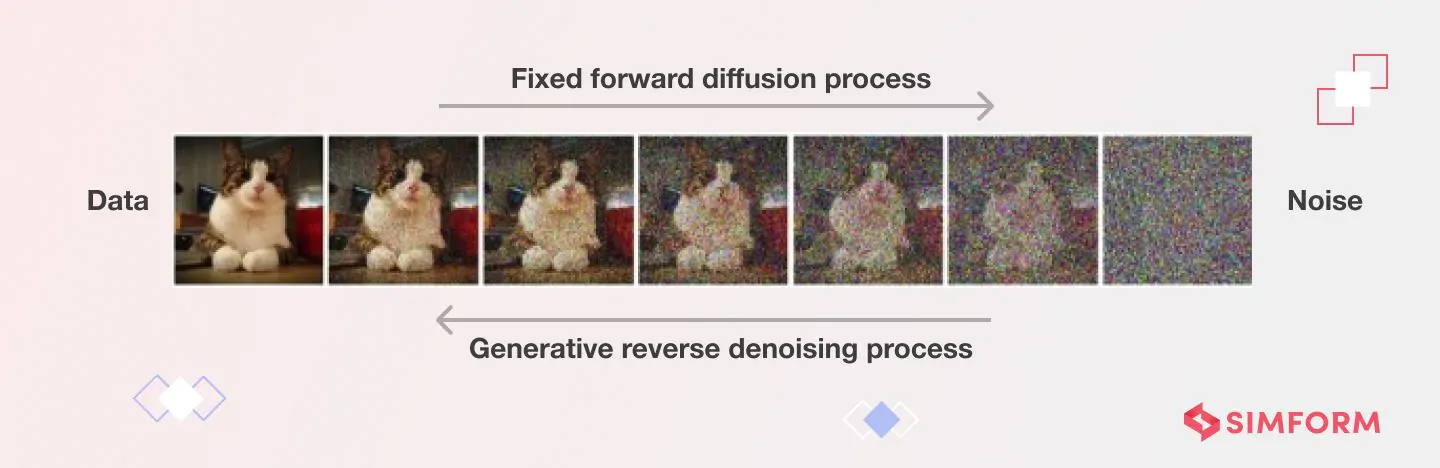

Ao contrário dos modelos autorregressivos convencionais que geram texto um token por vez, o Gemini Diffusion funciona refinando o ruído em texto coerente através de etapas iterativas – um processo que o Google afirma entregar respostas "significativamente mais rápidas do que até mesmo nosso modelo mais rápido até agora".

"Isso representa uma mudança fundamental na forma como pensamos sobre a geração de linguagem", disse um pesquisador sênior de IA familiarizado com a tecnologia de difusão, mas não afiliado ao Google. "Estamos vendo o potencial para uma melhoria de 4 a 5 vezes na velocidade de saída ponta a ponta em comparação com modelos autorregressivos de tamanho semelhante. Isso é como saltar várias gerações de hardware apenas através da inovação de software."

Quebrando a Barreira Sequencial

A inovação técnica por trás do Gemini Diffusion aborda uma limitação central dos sistemas de IA atuais. Modelos de linguagem tradicionais como GPT-4 ou versões anteriores do Gemini funcionam sequencialmente, prevendo cada palavra com base no que veio antes. Essa abordagem, embora eficaz, limita inerentemente a velocidade e pode levar a problemas de coerência em saídas mais longas.

Modelos de difusão adotam uma abordagem radicalmente diferente. Em vez de construir texto peça por peça, eles começam com ruído aleatório e o refinam gradualmente em conteúdo significativo através de etapas repetidas de remoção de ruído.

"O processo todo é mais como esculpir do que escrever", explicou um analista da indústria especializado em arquiteturas de IA. "O modelo considera o contexto completo em cada etapa de refinamento, permitindo naturalmente a correção de erros e uma coerência holística que é mais difícil de alcançar com a geração token a token."

Resultados de benchmark divulgados pelo Google mostram que o Gemini Diffusion atinge uma velocidade média de amostragem de 1.479 tokens por segundo – uma melhoria substancial em relação aos modelos anteriores – embora isso venha com aproximadamente 0,84 segundos de sobrecarga para cada geração.

Desempenho Misto nos Benchmarks Revela Pontos Fortes e Limitações

Os dados de benchmark do Google revelam o perfil de desempenho irregular, mas promissor, do Gemini Diffusion. O modelo mostra força particular em tarefas de codificação, alcançando 89,6% no HumanEval e 76,0% no MBPP – praticamente idêntico às pontuações do Gemini 2.0 Flash-Lite de 90,2% e 75,8%, respectivamente.

No entanto, o modelo mostra limitações notáveis em certas áreas. No teste de raciocínio BIG-Bench Extra Hard, o Gemini Diffusion marcou 15,0% em comparação com 21,0% do Flash-Lite. Da mesma forma, no benchmark multilíngue Global MMLU, o Diffusion alcançou 69,1% versus 79,0% do Flash-Lite.

"O que estamos vendo é uma tecnologia que se destaca em tarefas que exigem refinamento iterativo, como codificação, onde pequenos ajustes localizados dentro de um contexto global são valiosos", observou um especialista em aprendizado de máquina em uma grande instituição financeira. "O desempenho mais fraco em tarefas de raciocínio sugere que a difusão pode precisar de ajustes arquiteturais para aplicações com muita lógica."

Apesar dessas limitações, o Google DeepMind destaca a eficiência de parâmetros do modelo, alcançando pontuações de benchmark comparáveis a modelos autorregressivos maiores em muitos domínios.

Desafios Técnicos no Projeto e Implementação de Modelos de Difusão de Texto

| Categoria do Desafio | Desafio Específico | Descrição |

|---|---|---|

| Computacional e Eficiência | Demandas de Processamento | Requer centenas a milhares de etapas de remoção de ruído, cada uma envolvendo uma passagem completa para frente através de uma rede neural |

| Problemas de Latência | A inferência pode ser notavelmente lenta, limitando aplicações em tempo real | |

| Consumo de Memória | Requisitos significativos de memória com grandes mapas de características intermediárias durante cada etapa da difusão reversa | |

| Implementação Específica p/ Texto | Limitações da Arquitetura | Não pode se beneficiar do cache KV devido ao cálculo de atenção não causal |

| Limitações da Transição Q_absorb | Remove ruído de tokens apenas uma vez, limitando a capacidade de editar tokens gerados anteriormente | |

| Ineficiências de Processamento | Tokens mascarados não fornecem informação, mas ainda consomem recursos computacionais | |

| Comprimento de Geração Fixo | Grande obstáculo para a geração de texto aberta em comparação com modelos autorregressivos | |

| Controle e Alinhamento | Problemas de Precisão do Texto | Dificuldade em aderir ao conjunto completo de condições especificadas no texto de entrada |

| Problemas de Fidelidade | Frequentemente gera conteúdo com significado ou detalhes errados, apesar da saída parecer natural | |

| Saídas Inconsistentes | Amostras aleatórias diferentes podem produzir resultados vastamente distintos com o mesmo prompt | |

| Renderização de Texto | Dificuldade em renderizar texto correto e controlar o estilo do texto na geração de imagens | |

| Teórico e Aprendizado | Desafios da Função de Pontuação | O desempenho está ligado ao aprendizado preciso da função de pontuação |

| Equilíbrio de Trade-offs | Encontrar o equilíbrio ideal entre velocidade, custo e qualidade permanece sem solução | |

| Implementação | Restrições de Recursos | Throughput de computação, capacidade de memória e orçamento de energia limitados em dispositivos de borda (edge devices) |

| Gerenciamento Térmico | Muitos dispositivos dependem de resfriamento passivo, tornando cargas de trabalho sustentadas de alto throughput impraticáveis | |

| Integração na Produção | Lidar com latência variável e alto uso de memória complica a integração do sistema | |

| Preocupações com Segurança | Prevenir o uso indevido requer salvaguardas robustas que adicionam sobrecarga | |

| Controle de Versão | Atualizações podem quebrar aplicações subsequentes ao fazer fine-tuning para casos de uso específicos |

Edição e Refinamento: Uma Nova Força da IA

Talvez a vantagem mais significativa da abordagem de difusão seja sua aptidão natural para tarefas de edição e refinamento.

"Em cada etapa de remoção de ruído, o modelo pode autocorriger erros factuais ou sintáticos", disse um professor de ciência da computação que estuda IA generativa. "Isso torna a difusão particularmente poderosa para tarefas como derivações matemáticas ou correções de código, onde você precisa manter a consistência em relações complexas."

Essa capacidade de autocorreção oferece uma solução potencial para desafios como alucinações e desvios (drift) que têm afetado grandes modelos de linguagem. Ao considerar a saída completa em cada etapa, em vez de apenas os tokens anteriores, o Gemini Diffusion pode manter melhor coerência em passagens mais longas.

Acesso Antecipado e Implicações Futuras

O Google abriu uma lista de espera para desenvolvedores interessados em testar o Gemini Diffusion, descrevendo-o como "uma demonstração experimental para ajudar a desenvolver e refinar modelos futuros".

Para usuários profissionais e investidores, as implicações vão muito além do lançamento de um único produto. Modelos de difusão poderiam alterar fundamentalmente o cenário da IA se continuarem a demonstrar vantagens em velocidade e qualidade.

"Estamos potencialmente vendo o começo de uma era híbrida", sugeriu um estrategista de investimento em IA em um grande fundo de hedge. "Os próximos dois anos podem ser dominados por modelos que combinem a velocidade e coerência da difusão com os pontos fortes de raciocínio token a token das abordagens autorregressivas."

A tecnologia parece especialmente promissora para ferramentas de edição interativa, onde os usuários poderiam refinar saídas da IA durante a geração ou aplicar restrições dinamicamente. Isso poderia permitir um controle mais preciso do que a engenharia de prompt 'single-shot' atual permite.

Implicações de Mercado da Mudança de Difusão

Para traders e investidores observando o espaço da IA, o Gemini Diffusion representa tanto oportunidade quanto disrupção.

"Essa inovação reduz a curva de custo para inferência em escala", disse um analista do setor de tecnologia. "Empresas fortemente investidas em infraestrutura otimizada para modelos autorregressivos podem precisar mudar o foco, enquanto aquelas trabalhando em capacidades de edição e experiências de IA interativas podem ver sua posição fortalecida."

O anúncio sinaliza uma competição crescente na corrida pela IA, com o Google aproveitando sua profundidade de pesquisa para diferenciar suas ofertas das de OpenAI, Anthropic e outros. Para clientes corporativos, a promessa de geração mais rápida com qualidade comparável poderia reduzir significativamente os custos de computação.

No entanto, barreiras significativas permanecem antes que os modelos de difusão possam se tornar amplamente adotados. O ecossistema de ferramentas, auditorias de segurança e melhores práticas de implementação para difusão de texto permanece muito menos maduro do que para modelos autorregressivos. Adotantes iniciais podem enfrentar desafios de integração e qualidade irregular em diferentes domínios.

"A grande questão é se a difusão de texto é o futuro ou apenas um componente importante dele", observou um especialista em governança de IA. "O sucesso provavelmente pertencerá a sistemas que combinem difusão com raciocínio token a token, recuperação de informação e camadas de segurança robustas."