Avanço da IA de Código Aberto Ameaça Gigantes da Indústria de Animação de Vídeos

Novo modelo de 14 bilhões de parâmetros supera sistemas proprietários, levantando questões sobre a dinâmica de mercado e os fossos competitivos na inteligência artificial

Uma transformação profunda está ocorrendo no setor de geração de vídeo por inteligência artificial, à medida que pesquisadores da Alibaba lançam o Wan-Animate-14B, um modelo de código aberto que, segundo relatos, supera sistemas proprietários líderes do setor na criação de animações de personagens realistas. O desenvolvimento sinaliza uma potencial disrupção para os atores estabelecidos que cobram preços premium por capacidades semelhantes.

Lançado através de um anúncio oficial em 19 de setembro de 2025, o modelo demonstra um desempenho sem precedentes em duas áreas críticas: animar imagens estáticas de personagens para imitar movimentos humanos a partir de vídeos de referência e substituir personagens de forma contínua em filmagens existentes. Estudos de preferência humana indicam que os usuários favorecem a saída do Wan-Animate em relação tanto ao Act-Two da Runway quanto ao DreamActor-M1 da ByteDance, dois sistemas comerciais que têm dominado o mercado profissional.

O Algoritmo Que Muda Tudo

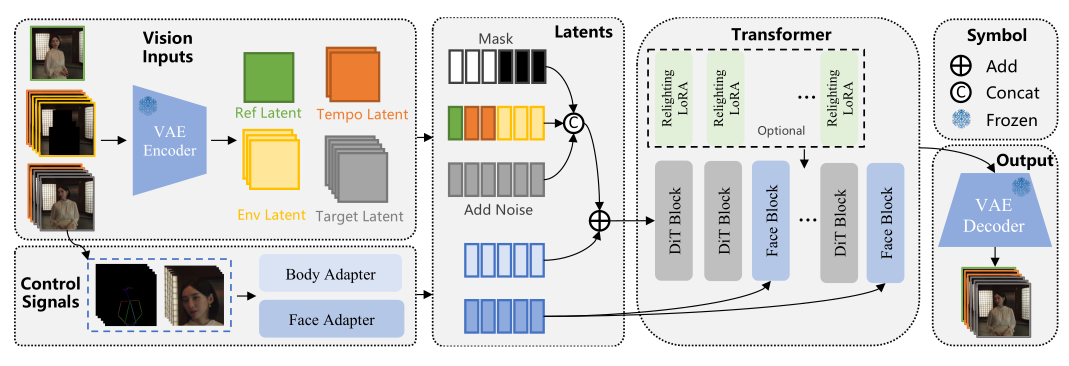

A arquitetura do Wan-Animate representa uma fusão sofisticada de tecnologias existentes, construída sobre o modelo de base Wan-I2V usando princípios de Diffusion Transformer. A inovação do sistema não reside em novos algoritmos revolucionários, mas em sua abordagem unificada para lidar com dupla funcionalidade dentro de uma única arquitetura de modelo.

O modelo opera em dois modos distintos. No modo de animação, ele gera vídeos onde um personagem de origem executa expressões e movimentos de um vídeo condutor, mantendo o fundo original. O modo de substituição vai além, substituindo o personagem original em um vídeo de referência por um novo personagem, combinando iluminação e condições ambientais através de um módulo LoRA (Low-Rank Adaptation) de iluminação especializada, treinado especificamente para ajuste dinâmico de luz.

Nossa análise interna revela o sofisticado mecanismo de controle do modelo, que desacopla o movimento corporal através de estruturas esqueléticas 2D das expressões faciais usando extração implícita de características. O sistema injeta informações de esqueleto espacial diretamente em latentes de ruído iniciais enquanto direciona dados de expressão facial através de mecanismos de atenção cruzada em blocos Transformer. Essa separação arquitetural permite o que os pesquisadores chamam de "replicação holística" de performances de referência com notável fidelidade.

A base do modelo na arquitetura Diffusion Transformer oferece vantagens significativas sobre os sistemas tradicionais baseados em UNet, particularmente em consistência temporal e qualidade geral do vídeo. No entanto, as demandas computacionais são substanciais, com usuários relatando erros de falta de memória mesmo em GPUs de ponta como a RTX 5090 ao tentar resolução de 1280x720 a 121 quadros, muitas vezes exigindo comprometimentos de resolução para implementação prática.

Validação de Mercado Mais Ampla do WAN 2.2

O Wan-Animate-14B surge da família de modelos mais ampla WAN 2.2, que tem obtido validação significativa de usuários em diversas comunidades criativas. O feedback em primeira mão do Reddit, X e YouTube demonstra melhorias substanciais na qualidade no controle de movimento, movimentos de câmera cinematográficos e aderência a prompts em comparação com a versão 2.1 anterior.

Nossos testes internos revelam que o WAN 2.2 oferece desempenho competitivo contra sistemas comerciais estabelecidos como Kling e Hailuo, no mesmo nível do Google Veo 3, particularmente em conteúdo cinematográfico de curta duração. As capacidades de composição do modelo, o controle dinâmico da câmera e o desempenho superior na renderização de texto são bastante notáveis. O licenciamento comercial estilo Apache tem atraído criadores que buscam alternativas a plataformas comerciais fortemente censuradas.

No entanto, a implementação no mundo real revela restrições práticas que podem afetar uma adoção mais ampla. Usuários relatam aumentos exponenciais nos tempos de renderização com maiores contagens de passos, com vídeos 720p em 15 passos produzindo resultados excelentes, mas sequências mais longas mostrando degradação da qualidade. A natureza "devoradora de VRAM" do sistema força comprometimentos de resolução mesmo em hardware premium, com configurações de 32GB de VRAM ainda exigindo ajustes para clipes estendidos.

O feedback da comunidade técnica identifica desafios persistentes, incluindo artefatos de morphing ocasionais, aparências "plásticas" nas saídas de texto-para-vídeo e características tonais supersaturadas em comparação com alternativas comerciais. A calibração da velocidade de movimento permanece problemática em sequências de ação rápida, embora os fluxos de trabalho de otimização Lightning e LightX2V ofereçam melhorias de velocidade a um certo custo de qualidade.

Disrupção de Mercado Através do Acesso Aberto

O momento do lançamento coincide com um crescente escrutínio dos investidores sobre as avaliações de inteligência artificial e a sustentabilidade competitiva. Empresas como a Runway, que garantiram financiamento com avaliações de bilhões de dólares parcialmente baseadas em suas capacidades de geração de vídeo, agora enfrentam competição direta de alternativas disponíveis gratuitamente.

Nossa análise de mercado sugere que o desenvolvimento exemplifica uma tendência mais ampla onde iniciativas de código aberto desafiam sistemas de IA proprietários. Padrões históricos no desenvolvimento de software indicam que alternativas abertas de alta qualidade muitas vezes comprimem as margens e forçam os incumbentes a inovar rapidamente ou a arriscar a obsolescência.

O desempenho do modelo contra sistemas comerciais estabelecidos levanta questões fundamentais sobre os fossos defensivos que cercam os atuais líderes de mercado. Vantagens tradicionais como acesso a dados, recursos computacionais e aquisição de talentos parecem menos decisivas quando os modelos fundamentais se tornam publicamente acessíveis.

Infraestrutura Computacional e Implicações de Investimento

Os requisitos de recursos do Wan-Animate apresentam tanto desafios quanto oportunidades em todo o ecossistema tecnológico. Dados de implementação no mundo real revelam as demandas computacionais substanciais do modelo, com usuários relatando limitações de memória mesmo em configurações de hardware premium. A exigência de modelos de especialistas duplos (alto ruído e baixo ruído), codificador de texto UMT5-XXL e componentes VAE especializados cria uma arquitetura de implementação complexa que sobrecarrega as configurações tradicionais de memória GPU.

As implementações multi-GPU utilizando os frameworks FSDP (Fully Sharded Data Parallel) e DeepSpeed Ulysses demonstram o potencial de escalabilidade do modelo, mas também ressaltam os investimentos em infraestrutura necessários para uma implementação prática. Relatos da comunidade de operação bem-sucedida exigindo gerenciamento cuidadoso de memória — com a resolução 720p tornando-se o padrão prático mesmo em sistemas de ponta — destacam o gargalo contínuo de hardware na geração de vídeo por IA.

Essa realidade computacional cria distintas oportunidades de investimento. Fabricantes de semicondutores especializados em arquiteturas GPU de alta memória podem ver uma demanda sustentada à medida que as cargas de trabalho de geração de vídeo se tornam mainstream. Provedores de infraestrutura em nuvem que oferecem plataformas otimizadas para inferência de IA poderiam capturar uma parcela significativa do mercado de organizações que buscam implementar capacidades avançadas de vídeo sem investimentos substanciais em hardware.

O surgimento de técnicas de otimização impulsionadas pela comunidade, incluindo fluxos de trabalho Lightning e melhorias nos mecanismos de atenção, sugere um ecossistema paralelo se desenvolvendo em torno de soluções de implementação eficientes. Empresas que desenvolvem ferramentas de otimização de modelos, sistemas de gerenciamento de memória e hardware de inferência especializado podem encontrar oportunidades de mercado substanciais à medida que a tecnologia se expande para além dos ambientes de pesquisa.

Transformação da Economia de Criação de Conteúdo

As indústrias de entretenimento e marketing enfrentam uma potencial reestruturação à medida que os custos de produção para animação de personagens de alta qualidade diminuem drasticamente, embora a adoção prática revele uma transição mais matizada do que o inicialmente antecipado. Criadores independentes e pequenos estúdios ganham acesso a capacidades anteriormente restritas a grandes casas de produção, mas a complexidade técnica e os requisitos computacionais criam novas barreiras de entrada.

Padrões de adoção da comunidade indicam o surgimento de um mercado bifurcado. Criadores profissionais desenvolvem fluxos de trabalho sofisticados combinando as capacidades cinematográficas do WAN 2.2 com pipelines de pós-processamento usando ferramentas como Topaz AI e GIMM-VFI para upscaling e interpolação. Essas abordagens híbridas permitem que as equipes aproveitem os pontos fortes do modelo em conteúdo de curta duração, ao mesmo tempo em que abordam suas limitações em sequências estendidas e restrições de resolução.

A força do modelo em movimentos dinâmicos de câmera e aderência a prompts beneficia particularmente os fluxos de trabalho de pré-visualização em cinema e publicidade. Estúdios relatam usar o sistema para desenvolvimento rápido de conceitos e comunicação direcional, embora a produção final ainda exija técnicas tradicionais para qualidade e consistência. O licenciamento estilo Apache remove barreiras legais que têm complicado a implementação comercial de modelos de código aberto anteriores.

No entanto, as limitações atuais da tecnologia — incluindo aumentos exponenciais nos tempos de renderização, restrições de resolução e gerenciamento de artefatos — sugerem que a adoção profissional provavelmente se concentrará em casos de uso específicos, em vez da substituição total de pipelines existentes. Agências de marketing experimentando conteúdo de influenciadores virtuais e criadores de mídia social produzindo vídeos de curta duração representam as aplicações comerciais mais imediatas.

Análise de Mercado Prospectiva

A dinâmica atual do mercado sugere vários temas de investimento emergindo deste desenvolvimento. A convergência das capacidades de IA de código aberto com as necessidades de criação de conteúdo profissional pode favorecer empresas que conseguem integrar e comercializar eficazmente tecnologias disponíveis gratuitamente, em vez de desenvolver alternativas proprietárias.

Provedores de infraestrutura que permitem a implementação e escalabilidade de modelos de IA podem ver um crescimento sustentado da demanda à medida que as organizações buscam implementar capacidades avançadas de geração de vídeo. Isso inclui fabricantes de hardware especializado, plataformas de computação em nuvem e empresas de software que oferecem ferramentas de otimização e implementação de modelos.

Empresas tradicionais de mídia e entretenimento podem precisar avaliar suas estratégias tecnológicas, potencialmente mudando o investimento do desenvolvimento de capacidades internas de IA para a aquisição e integração das melhores soluções abertas. Essa realocação poderia afetar os fluxos de capital de risco e a atividade de fusões no setor.

O cenário competitivo parece favorecer organizações com fortes capacidades de execução, relacionamentos com clientes e expertise em integração sobre aquelas que dependem principalmente de vantagens algorítmicas. À medida que a diferenciação técnica diminui, a inovação do modelo de negócios e a eficiência operacional tornam-se fatores de sucesso mais críticos.

Avaliação de Risco e Perspectivas de Mercado

Embora o Wan-Animate represente um progresso técnico significativo, vários fatores podem afetar seu impacto no mercado. Os requisitos computacionais do modelo limitam a acessibilidade imediata, e desafios de integração podem atrasar a adoção empresarial. As respostas regulatórias às capacidades de mídia sintética permanecem incertas, potencialmente afetando os cronogramas de implementação comercial.

No entanto, a tendência mais ampla em direção ao desenvolvimento de IA de código aberto parece sustentável, sugerindo que empresas dependentes de algoritmos proprietários de geração de vídeo podem enfrentar pressão contínua. Investidores podem se beneficiar ao monitorar as respostas competitivas dos atores estabelecidos e avaliar se as avaliações de mercado atuais refletem adequadamente essas mudanças tecnológicas.

O desenvolvimento ressalta o ritmo acelerado do avanço da IA e a dificuldade em manter fossos competitivos baseados unicamente em capacidades algorítmicas. À medida que o cenário tecnológico continua evoluindo, empresas de sucesso provavelmente serão aquelas que conseguem se adaptar rapidamente para alavancar novas capacidades enquanto constroem vantagens competitivas sustentáveis através da execução, relacionamentos com clientes e posicionamento estratégico.

Isenção de responsabilidade: Esta análise é baseada em informações publicamente disponíveis e não constitui aconselhamento de investimento. O desempenho passado não garante resultados futuros. Os leitores devem consultar assessores financeiros antes de tomar decisões de investimento.