Fidelity Lidera Investimento de US$ 1,1 Bilhão na Fabricante de Chips de IA Cerebras, Que Afirma Vantagem de Velocidade Sobre as GPUs da Nvidia

Insurreição do Silício: A Aposta de US$ 1,1 Bilhão da Cerebras Agita o Campo de Batalha do Hardware da IA

A Fidelity lidera uma rodada massiva avaliando a Cerebras em US$ 8,1 bilhões, sinalizando que as guerras de chips de IA estão longe de serem resolvidas.

SUNNYVALE, Califórnia — A Nvidia ainda pode dominar o mundo da computação de IA, mas seu domínio começa a ceder. Hoje, a Cerebras Systems arrecadou impressionantes US$ 1,1 bilhão em uma rodada Série G com excesso de demanda. O negócio, liderado pela Fidelity Management & Research juntamente com a Atreides Management, eleva a avaliação da startup para US$ 8,1 bilhões e a consolida como um dos mais ousados desafiantes ao império de GPUs da Nvidia.

Este financiamento chega em um ponto de virada crucial. A atenção da indústria mudou do treinamento de modelos de linguagem gigantescos para a execução deles em produção. Essa mudança expõe as fraquezas do hardware existente e abre as portas para empresas que constroem chips com um único objetivo em mente: inferência rápida e confiável.

A Velocidade é Agora a Verdadeira Arma

O dinheiro está jorrando porque a inferência – o ato de colocar modelos para funcionar – se tornou o gargalo da indústria. O treinamento antes monopolizava as manchetes, mas hoje as empresas se preocupam em cortar milissegundos dos tempos de resposta. Todo atraso pode frustrar usuários, desacelerar ferramentas como assistentes de código ou até mesmo prejudicar o posicionamento competitivo.

A Cerebras afirma que seus massivos sistemas em escala de wafer já rodam mais de 20 vezes mais rápido que as GPUs da Nvidia em modelos open-source líderes, de acordo com benchmarks da empresa terceirizada Artificial Analysis. A empresa afirma atender trilhões de tokens todos os meses, não apenas em laboratórios, mas em data centers de clientes, infraestrutura de nuvem e plataformas parceiras.

A lista de clientes parece um "quem é quem" da tecnologia. AWS, Meta, IBM e startups em ascensão como Mistral e Notion estão a bordo, juntamente com o Departamento de Energia e o Departamento de Defesa dos EUA. Até mesmo os desenvolvedores do Hugging Face parecem preferir a Cerebras: ela é agora a principal provedora de inferência na plataforma, lidando com mais de cinco milhões de solicitações mensais.

Construindo Chips em Casa

A Cerebras planeja direcionar grande parte desse novo capital para a fabricação nos EUA e para data centers domésticos. O momento não poderia ser melhor. Washington está impulsionando a independência de semicondutores por meio do CHIPS Act, e as agências querem reduzir sua dependência de um único fornecedor por razões de segurança nacional.

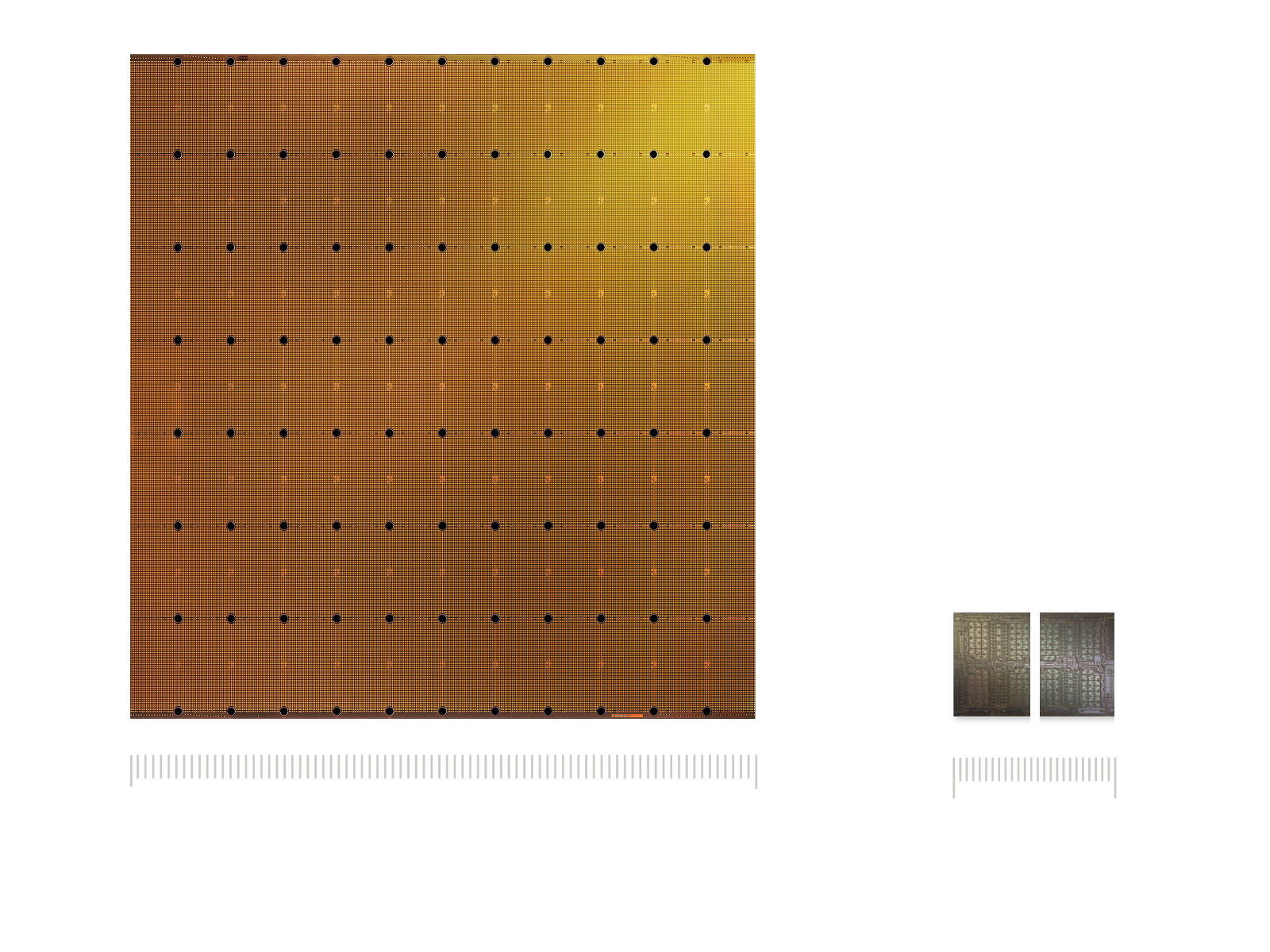

A estratégia da empresa pega emprestado uma página do manual da Nvidia: controlar todo o stack, desde o design do chip até a arquitetura do sistema e a entrega na nuvem. A diferença? Em vez de GPUs de propósito geral, a Cerebras está apostando em processadores especializados em escala de wafer, projetados exclusivamente para cargas de trabalho de inferência. Em uma era onde a Lei de Moore não entrega mais ganhos fáceis, a especialização pode se tornar o trunfo.

Uma Mudança Mais Ampla na Infraestrutura de IA

A Cerebras não está sozinha na busca por esta oportunidade. Concorrentes e players adjacentes também estão levantando grandes somas. A Groq fechou US$ 750 milhões em setembro, impulsionada por contratos do Oriente Médio. Empresas de fotônica como Celestial AI, Lightmatter e Ayar Labs juntas arrecadaram mais de US$ 800 milhões para corrigir gargalos de largura de banda.

Grandes gigantes da tecnologia também estão construindo seus próprios chips: MTIA da Meta, Maia da Microsoft, Inferentia da AWS e TPUs do Google. Cada um representa bilhões de dólares destinados a cortar a dependência da Nvidia. Coletivamente, esses movimentos confirmam uma coisa: a economia da inferência justifica um investimento pesado, mesmo que nem toda aposta valha a pena.

Analistas esperam que os gastos com infraestrutura de IA disparem para quase meio trilhão de dólares até 2026 e possivelmente US$ 2,8 trilhões até 2029. Mas esses números dependem de as empresas conseguirem manter as taxas de utilização altas o suficiente para justificar a expansão.

Utilização e a Dura Matemática

Por trás das manchetes, reside uma verdade mais espinhosa. Pesquisas mostram que a maioria das GPUs em clusters corporativos fica ociosa com muito mais frequência do que os modelos financeiros assumem. Mesmo em pico de demanda, muitas instalações operam bem abaixo de sua prometida utilização de 80–90%. Essa lacuna importa, especialmente quando data centers são financiados com bilhões em empréstimos.

De fato, a indústria já está se apoiando em estruturas de financiamento exóticas. Somente no primeiro semestre de 2025, empresas emitiram US$ 13,4 bilhões em títulos lastreados em ativos de data center e contraíram mais de US$ 11 bilhões em empréstimos lastreados em GPUs. Alguns negócios chegaram a roçar em defaults técnicos antes que os credores oferecessem isenções.

Adicione as restrições do mundo real – escassez na rede elétrica, lentidão nas atualizações de serviços públicos e oferta limitada de memória de alta largura de banda – e o cenário parece mais frágil do que muitos investidores assumem.

Quão Mais Rápido, Realmente?

As alegações de benchmark da Cerebras também levantam sobrancelhas. Seus números vêm principalmente da Artificial Analysis, uma empresa com transparência limitada em comparação com padrões estabelecidos como o MLPerf. Enquanto isso, a Nvidia continua a extrair mais desempenho de sua pilha de software. Otimizações como TensorRT e quantização avançada podem estreitar as lacunas de desempenho sem novo hardware, tornando as comparações diretas difíceis.

Chips especializados frequentemente brilham em casos de uso restritos, mas tropeçam quando as cargas de trabalho ficam desorganizadas. Implantações no mundo real não se parecem com benchmarks polidos – elas envolvem tráfego imprevisível, maiores comprimentos de contexto e demanda intermitente. É aí que a economia, e não os slides de marketing, decidirá os vencedores.

O Que os Investidores Devem Realmente Observar

Para os investidores, alegações chamativas de throughput não são suficientes. As métricas reais são simples: custo por mil tokens na latência alvo, tempo até o primeiro token, energia consumida por inferência e quão consistentemente os sistemas atingem as metas de nível de serviço. Auditorias independentes sob cargas de trabalho realistas adicionariam muito mais credibilidade do que demonstrações escolhidas a dedo.

Alguns analistas argumentam que apostas mais seguras residem nas "ferramentas básicas" da infraestrutura de IA – fornecedores de memória, sistemas de resfriamento, serviços públicos – porque eles se beneficiam independentemente de qual fabricante de chips sair vitorioso. Startups de inferência especializadas como a Cerebras ainda podem prosperar, mas podem se encaixar melhor como apostas de tamanho de opção em um portfólio, em vez de participações centrais.

E não se esqueça da sombra iminente dos hyperscalers. À medida que AWS, Meta, Google e Microsoft continuam a lançar seus próprios aceleradores, o mercado para chips de terceiros pode encolher para nichos onde custo, soberania ou desempenho bruto os tornam indispensáveis.

Um Mercado no Limite

A corrida para construir infraestrutura de IA ecoa o boom das telecomunicações dos anos 1990, quando a superconstrução deixou um rastro de ativos ociosos. As projeções de hoje exigem um crescimento de receita impressionante para acompanhar o fluxo de capital. Se essa lacuna não for fechada, a bolha pode estourar.

Os resultados variam amplamente. No melhor dos casos, a Cerebras prova sua vantagem, conquista a adoção por hyperscalers e entra nos mercados públicos como uma verdadeira alternativa à Nvidia. No cenário intermediário, ela domina cargas de trabalho selecionadas enquanto a Nvidia mantém a coroa em outros lugares. O pior cenário? Seus benchmarks perdem força, a adoção diminui e a queima de caixa força uma venda ou fusão.

Os investidores seriam sábios em pedir evidências concretas: métricas auditadas de implementações em produção, contratos de energia garantidos, fornecimento confirmado de memória crítica e estruturas de dívida claras. É isso que separará desafiadores duradouros de sonhadores esperançosos.

A rodada de US$ 1,1 bilhão ressalta a questão central na infraestrutura de IA hoje: chips especializados podem conquistar uma fatia real de mercado, ou o ecossistema da Nvidia e suas implacáveis melhorias de software a manterão no controle? A resposta não virá de slides de PowerPoint ou de rodadas de financiamento recordes. Ela virá de quão bem esses sistemas se desempenham em produção, em escala, sob pressão. Por enquanto, porém, investidores de grande porte estão apostando que a Cerebras ainda tem uma chance de lutar.