GLM-4.6 da China Mirando a Vantagem de Codificação de IA do Vale do Silício — a uma Fração do Custo

Novo modelo rivaliza com o Claude Sonnet 4 em tarefas de programação práticas, enquanto reduz o uso de tokens em 30%, abrindo caminho para a IA da China no mercado global de desenvolvedores.

A indústria de IA da China lançou um desafio ousado. A Zhipu, uma das empresas de IA mais ambiciosas do país, acaba de lançar o GLM-4.6, um modelo focado em codificação que, de acordo com avaliações da indústria, se iguala ao Claude Sonnet 4 da Anthropic em tarefas de programação cotidianas. E o melhor de tudo? Ele faz isso enquanto reduz os custos em até 85%.

Este lançamento ocorre no meio de uma movimentada temporada de lançamentos de setembro, que já viu o GPT-5 Codex da OpenAI, o Claude Sonnet 4.5 da Anthropic e o V3.2 da DeepSeek chegarem ao mercado. Ao contrário das batalhas anteriores que giravam em torno da exibição de pontuações de benchmarks, a corrida agora está se voltando para algo que os desenvolvedores realmente se importam: ferramentas acessíveis que cumprem o trabalho.

Desempenho Que Impressiona

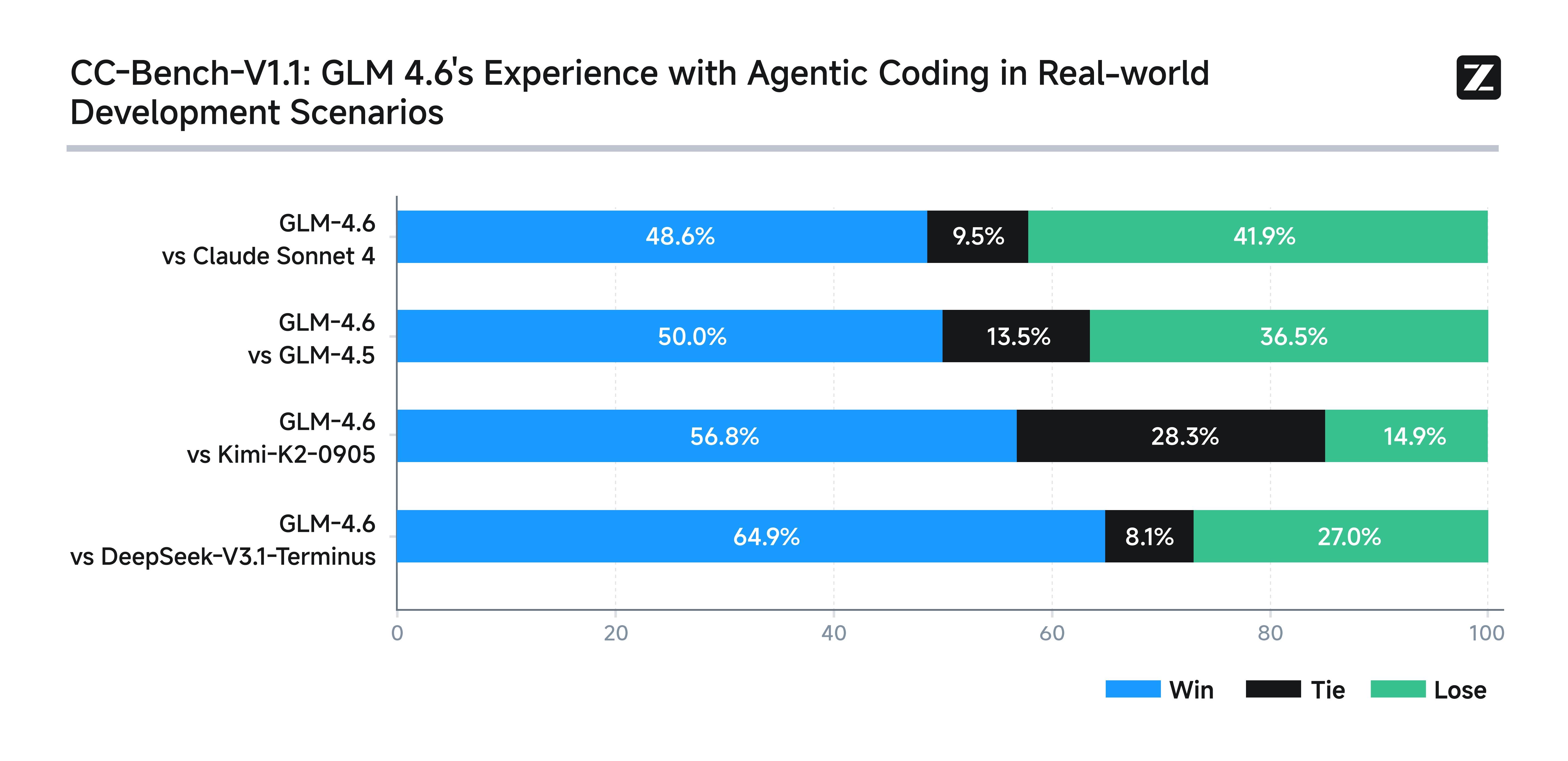

Para testar o GLM-4.6, a Zhipu configurou 74 desafios de codificação do mundo real dentro do ambiente de desenvolvimento Claude Code. Em seguida, eles tornaram os resultados públicos para verificação no Hugging Face. O resultado surpreendeu a muitos: o GLM-4.6 não apenas superou o Claude Sonnet 4 em várias tarefas, como também deixou todos os outros concorrentes chineses para trás.

Os desafios não eram apenas benchmarks acadêmicos secos. Em vez disso, eles imitavam problemas reais de desenvolvedores — coisas como construir interfaces de usuário, automatizar o processamento de documentos e criar painéis com muitos dados.

Um teste de destaque pediu ao modelo para comprimir um artigo de pesquisa de 64 páginas da OpenAI em um infográfico HTML limpo de uma página. Os avaliadores chamaram o resultado de “sólido e bem estruturado”. Não era tão visualmente polido quanto a saída do Claude Sonnet 4.5, mas superou modelos que custam muitas vezes mais.

Em outro teste, o modelo construiu um painel de dados “Turismo da Golden Week 2024”, completo com animações e gráficos densos. Revisores independentes disseram que o desempenho do GLM-4.6 estava no mesmo nível do Claude Sonnet 4.5 — uma grande conquista para qualquer negócio que dependa de painéis elegantes e funcionais.

Ainda assim, nem tudo foi impecável. No SWE-bench Verified, um benchmark de codificação amplamente utilizado, o GLM-4.6 marcou 68%, empatando com o DeepSeek-V3.2, mas ficando aquém dos 77,2% do Claude Sonnet 4.5.

Eficiência: A Arma Secreta

Onde o GLM-4.6 realmente brilha é na eficiência. Ele consome cerca de 30% menos tokens que seu predecessor, o GLM-4.5. Para tarefas de raciocínio, a queda é ainda mais acentuada: de 16.000 tokens para apenas 9.000. Isso o torna o modelo de raciocínio chinês mais enxuto do mercado.

Os tempos de resposta giram em torno de 35 segundos — rápido o suficiente para colocá-lo entre os modelos “de segunda linha” mais rápidos.

Como um membro da equipe de engenharia da CTOL.digital colocou, “Os desenvolvedores não querem mais apenas campeões de placar. Eles querem modelos que lidem com conversas reais, trabalhem com ferramentas e não esgotem os orçamentos.” O GLM-4.6 parece atender a esses requisitos.

Um Preço Que Disrompe o Mercado

Eficiência significa economia, e a Zhipu está repassando essas economias. Seu Plano de Codificação GLM agora custa a partir de apenas 20 yuans — cerca de três dólares (aproximadamente R$ 15,00) — por mês. Isso é aproximadamente um sétimo do custo dos rivais. O plano cobre “dezenas a centenas de bilhões” de tokens por mês, uma franquia generosa o suficiente para a maioria dos desenvolvedores em tempo integral.

Além disso, a assinatura vem com reconhecimento de visão, capacidades de busca e integração plug-and-play com ferramentas como Claude Code, Roo Code e Cline. Para os desenvolvedores, a proposta de valor é simples: desempenho próximo ao do Claude 4 por uma bagatela.

Atualizações Técnicas e Compensações

A Zhipu não apenas ajustou os preços. O GLM-4.6 expande sua janela de contexto de 128.000 tokens para 200.000, superando os 128.000 do DeepSeek-V3.2. Isso permite que ele lide com bases de código extensas ou documentação longa de uma só vez.

O modelo também mostra maior capacidade de seguir instruções, melhor aritmética e saída de linguagem mais limpa em comparação com versões anteriores. Mas há ressalvas. Os erros de sintaxe saltaram para 13% em várias linguagens de programação, em comparação com apenas 5,5% no GLM-4.5. Desenvolvedores que trabalham em Go notarão isso mais do que a maioria.

Há outra peculiaridade também: em tarefas de raciocínio longas e complexas, o GLM-4.6 às vezes desiste cedo em vez de forçar uma resposta. Os revisores chamaram isso de “tendência à concessão” — provavelmente o preço de sua otimização agressiva de tokens.

O Cenário Geral: Soberania de Chips

Por baixo da superfície, reside algo com um peso estratégico ainda maior: a independência de chips. O GLM-4.6 é o primeiro modelo de produção a executar inferência de precisão mista FP8+Int4 em chips Cambricon. Ele também roda nativamente em FP8 em hardware Moore Threads usando vLLM.

Se essas otimizações se mantiverem, as empresas chinesas podem finalmente diminuir sua dependência de GPUs NVIDIA — uma vulnerabilidade chave dadas as restrições de exportação dos EUA. Como a equipe de engenharia da CTOL.digital resumiu: “Se o treinamento e a inferência rodarem sem problemas em chips domésticos, a China construirá uma pilha de IA mais autônoma.”

A Rivalidade Aquece

A onda de lançamentos de modelos de setembro destaca o quão acirrada se tornou a corrida de codificação de IA. O DeepSeek-V3.2 reduziu seus preços de API em mais da metade. O GPT-5 Codex da OpenAI introduziu o corte de tokens de “pensamento” para reduzir custos. O Claude Sonnet 4.5 da Anthropic avançou no raciocínio complexo.

Empresas chinesas, outrora consideradas seguidoras, agora estão inovando de maneiras que chamam a atenção global. A combinação de eficiência, integração de chips e preços baixos do GLM-4.6 não é um acidente — faz parte de uma estratégia clara para conquistar desenvolvedores em todo o mundo.

O modelo já está disponível: usuários internacionais podem encontrá-lo em z.ai, usuários chineses em bigmodel.cn, e versões de código aberto estão chegando ao Hugging Face e ModelScope. Aplicativos de chat para consumidores e APIs corporativas também estão o implementando.

O Que os Desenvolvedores Estão Dizendo

O feedback prático tem sido promissor. Desenvolvedores relatam geração de front-end mais suave, menos travamentos e recriação rápida de projetos antigos em frameworks modernos como Vue 3. Alguns até construíram agentes completos que usam ferramentas para extrair dados e gerar documentação local sem problemas.

Em cenários de front-end, o GLM-4.6 muitas vezes se iguala ou até supera o Claude 4. Ainda assim, o Claude Sonnet 4.5 mantém sua vantagem em raciocínio pesado e tarefas de documentos longos.

Conclusão

No cenário atual da IA, o poder bruto não é mais a única história. Estratégia de implantação, eficiência e custo importam tanto quanto. O GLM-4.6 equilibra os três. Não é o de melhor desempenho absoluto, mas é bom o suficiente na maioria dos casos — e muito mais barato.

Para muitos desenvolvedores, essa combinação será irresistível. Um analista o chamou de “o modelo de codificação doméstico mais utilizável” e um desafiante credível às ofertas ocidentais.

Se isso marca o início da competitividade chinesa de longo prazo ou apenas uma vantagem temporária, ainda está para ser visto. Mas uma coisa é clara: em outubro de 2025, o GLM-4.6 mudou a conversa sobre o que os desenvolvedores devem esperar pagar por codificação de IA de nível de fronteira.